Robots Exclusion Checker es una potente extensión de Chrome diseñada para garantizar que tu contenido esté accesible para los motores de búsqueda. Esta herramienta te ofrece una visualización clara del estado de rastreo e indexación de cualquier URL, utilizando un sistema de colores que facilita la identificación de problemas. Ya seas un propietario de negocio local o un profesional del SEO, esta extensión puede convertirse en tu mejor aliada para evitar bloqueos innecesarios en tu web.

¿Qué es el archivo robots.txt y cómo ayuda a robots exclusion checker?

El archivo robots.txt es un archivo de texto que se coloca en la raíz de tu sitio web y proporciona directrices a los motores de búsqueda sobre qué páginas o secciones deben rastrearse o no. Aunque este archivo no controla directamente la indexación, sí define la accesibilidad de las páginas para los rastreadores.

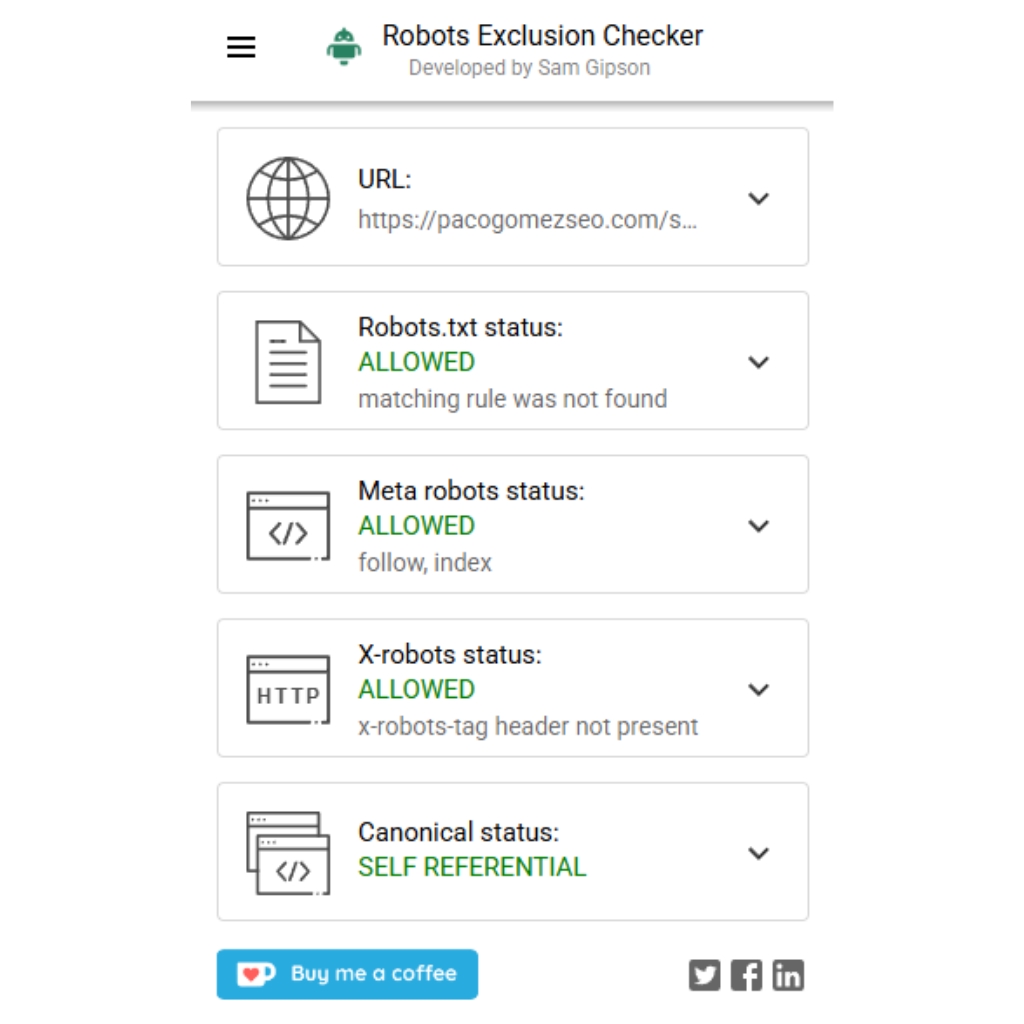

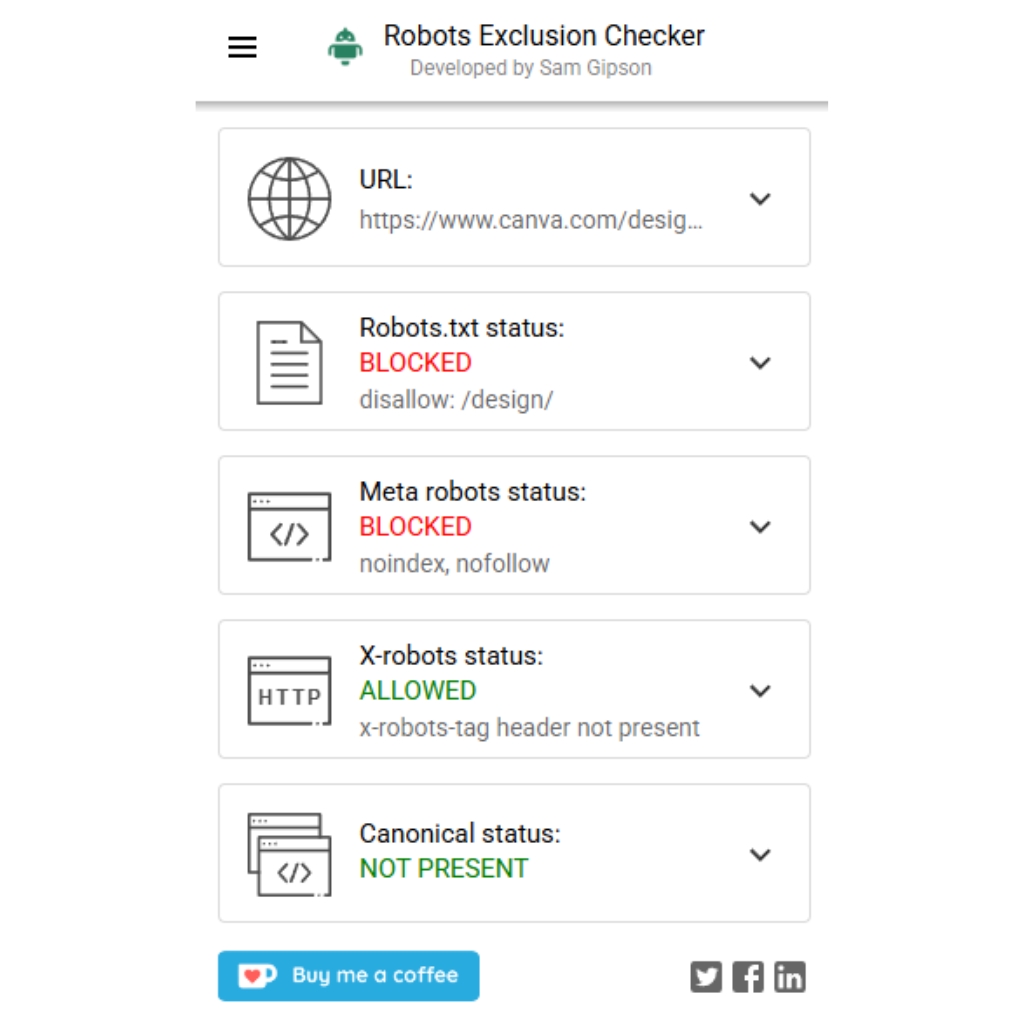

Con robots exclusion checker, puedes saber al instante si una URL está bloqueada para los motores de búsqueda. La extensión marca en rojo aquellas URLs que tienen restricciones en el archivo robot exclusion, mostrándote incluso la línea exacta en el archivo robots.txt con la instrucción conflictiva. Si la URL es accesible, la extensión la señalará en verde, dándote tranquilidad sobre la correcta visibilidad de tu contenido.

Metaetiqueta robots: cómo utilizarla junto a robot exclusion checker

Las metaetiquetas robots permiten un control más granular sobre cómo se deben comportar los motores de búsqueda en cada página de tu sitio web. Estas etiquetas se colocan en el HTML de cada URL y definen acciones específicas como:

- noindex: Impide que la página aparezca en los resultados de búsqueda.

- nofollow: Evita que los robots sigan los enlaces de la página.

- noarchive: Prohíbe que Google muestre una copia en caché de la página.

- notranslate: Evita que Google ofrezca traducción en las SERP.

- noimageindex: Impide que Google indexe las imágenes de la página.

Un ejemplo de metaetiqueta robots sería:

<meta name="robots" content="noindex, nofollow">

Con robots exclusion checker, puedes comprobar fácilmente si una metaetiqueta está funcionando correctamente. Solo tienes que hacer clic en la extensión y ver si el indicador es verde (accesible) o rojo (bloqueado).

Cómo robots exclusion checker ayuda con la etiqueta x-robots-tag

La x-robots-tag es otra herramienta para controlar el rastreo e indexación de las páginas web, especialmente útil para archivos no HTML, como PDFs. A diferencia de las metaetiquetas, se aplica a nivel del servidor, lo que permite una gestión masiva de directrices.

La extensión robots exclusion checker muestra el estado de la etiqueta x-robots-tag en cada URL con su sistema de colores:

- Verde: La URL es accesible y cumple las directrices de rastreo.

- Rojo: La URL tiene restricciones que podrían afectar la indexación.

Cómo utilizar robots exclusion checker con la etiqueta rel=canonical

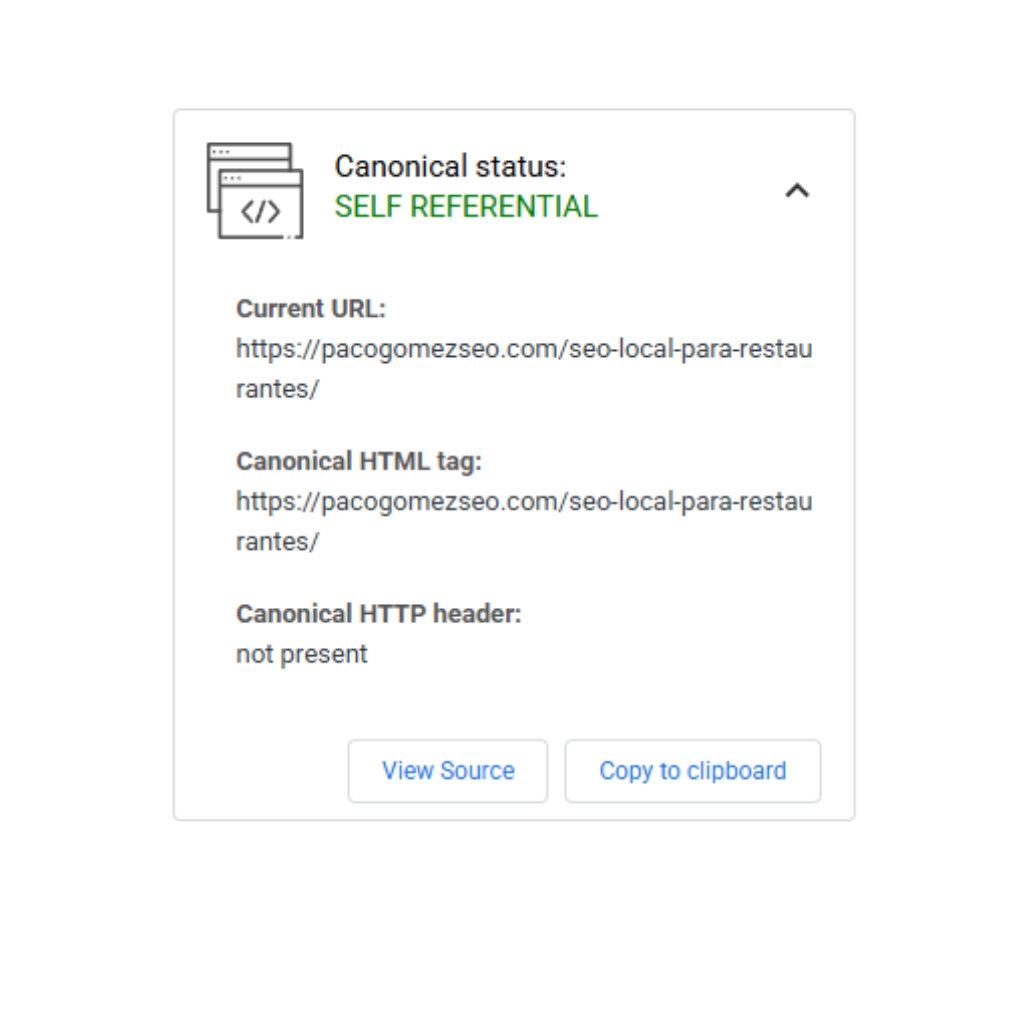

La etiqueta rel=canonical es crucial para evitar problemas de contenido duplicado en tu sitio web. Esta etiqueta indica a los motores de búsqueda cuál es la versión canónica de una página, ayudando a consolidar el SEO y evitar la dispersión de autoridad.

<link rel="canonical" href="https://www.ejemplo.com/pagina-preferida">

Con robots exclusion checker, puedes identificar fácilmente si una URL está canonicalizada incorrectamente. Si la extensión muestra el color amarillo, significa que hay una canonicalización en curso, y te indicará la URL a la que estás redirigiendo.

Mejora tu SEO con robots exclusion checker

Usar robots exclusion checker no solo te permite detectar problemas técnicos rápidamente, sino que también optimiza tu estrategia de SEO. Al verificar continuamente tu robot exclusion, te aseguras de que tu contenido sea accesible para los motores de búsqueda, mejorando la visibilidad de tu web y, en última instancia, atrayendo más tráfico orgánico.

¿A qué esperas para probar esta herramienta? Con un solo clic, tendrás un diagnóstico completo de tu robots exclusion, optimizando tu sitio web y asegurando que nada impida que Google y otros buscadores encuentren tu contenido.